Análise e Previsão do Rendimento das Culturas Agrícolas: A Jornada na Etapa 1 do Projeto

Neste artigo, vou compartilhar a primeira etapa de um projeto de Data Science voltado para a previsão do rendimento das culturas agrícolas de soja, milho e trigo. O objetivo desta fase foi desenvolver modelos de machine learning para prever com precisão a produção dessas culturas, utilizando dados climáticos, de solo e práticas agrícolas. Também vou falar sobre os desafios que enfrentei ao longo do projeto, as soluções que implementei para superá-los e os insights obtidos com as previsões.

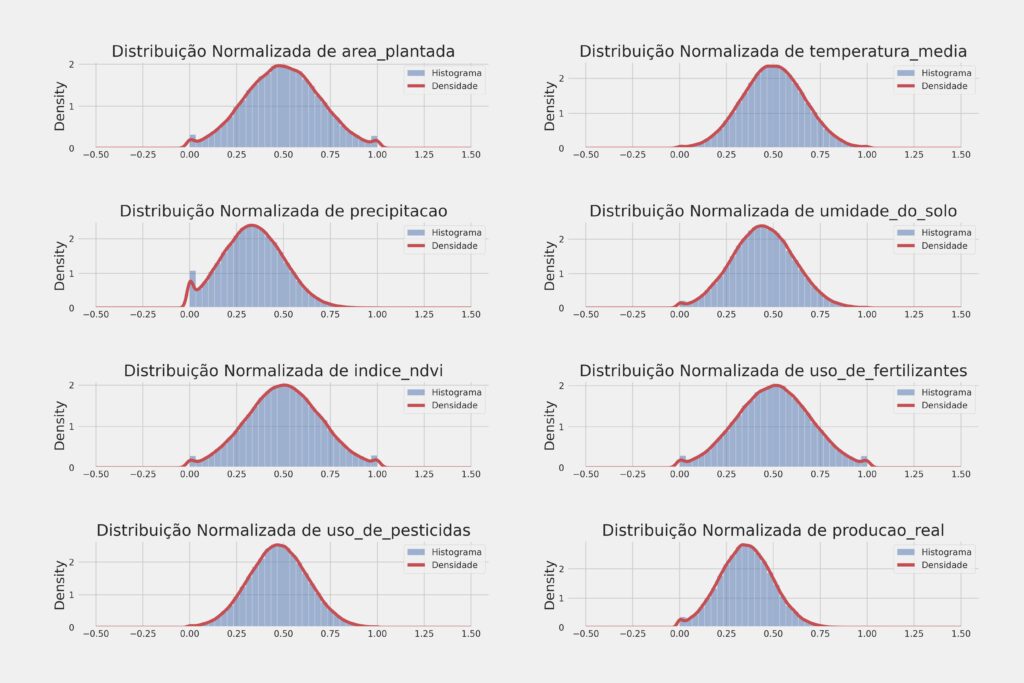

Essa fase do projeto envolveu uma intensa aplicação de engenharia de features para ajustar os dados e garantir que os algoritmos pudessem captar os padrões necessários para previsões precisas. Além disso, testei diversos modelos de machine learning para encontrar o melhor ajuste, incluindo K-Nearest Neighbors (KNN), Random Forest, XGBoost e redes neurais. Ao final, escolhi o XGBoost pela sua capacidade de generalizar bem os dados e pela velocidade de processamento.

1. Desafios na Escolha do Modelo de Machine Learning

Um dos principais desafios foi encontrar um modelo de machine learning que conseguisse capturar padrões complexos nos dados e fazer previsões precisas. Os dados utilizados foram sintéticos, mas refletiam condições reais de colheitas agrícolas, com variáveis que incluíam temperatura, precipitação, umidade do solo e NDVI (índice de vegetação). Essas variáveis são naturalmente voláteis e apresentam interações não lineares, o que torna a modelagem desafiadora.

Para melhorar a precisão dos modelos, investi fortemente em engenharia de features, criando novas variáveis a partir das já existentes e ajustando os dados para que os algoritmos pudessem processá-los de forma mais eficaz. Testei várias abordagens e algoritmos para encontrar a melhor opção.

Modelos Testados:

- K-Nearest Neighbors (KNN): Apesar de ser um modelo fácil de entender, não conseguiu lidar bem com a complexidade dos dados.

- Random Forest: Teve um bom desempenho, mas apresentava um tempo de processamento maior, o que poderia ser problemático ao lidar com grandes quantidades de dados.

- Redes Neurais: Foram testadas, mas mostraram resultados semelhantes aos obtidos com o XGBoost, embora exigissem mais ajustes e maior tempo de treinamento.

- XGBoost: Escolhi esse modelo devido à sua capacidade de lidar bem com dados complexos, generalizar de forma eficiente e ser rápido no processamento.

2. Resultados dos Modelos e Avaliação de Desempenho

Depois de muitas tentativas e ajustes, consegui resultados satisfatórios com o XGBoost para prever o rendimento das culturas. Abaixo, compartilho os principais resultados para a previsão da produção real, bem como os resultados específicos para as culturas de soja, milho e trigo.

Resultados para a Previsão da Produção Real:

- Erro Quadrático Médio (MSE): 0.0009176347928454376

- Erro Absoluto Médio (MAE): 0.019907656074337622

- Coeficiente de Determinação (R²): 0.9990707592909117

Esses resultados mostram que o modelo conseguiu capturar bem a relação entre as variáveis de entrada e a produção, com um R² próximo de 1, indicando que quase toda a variabilidade dos dados foi explicada pelo modelo. No entanto, ainda havia espaço para melhorar a precisão das previsões específicas para cada cultura.

Resultados para Soja, Milho e Trigo:

- Erro Quadrático Médio (MSE): 0.000332

- Erro Absoluto Médio (MAE): 0.010562

- Coeficiente de Determinação (R²): 0.999442

Os resultados acima mostram uma melhoria na precisão das previsões para as culturas individuais. A menor margem de erro (MSE e MAE) e o alto R² indicam que o modelo conseguiu fazer previsões precisas para soja, milho e trigo, capturando os padrões nos dados históricos e conseguindo generalizar bem.

Validação Cruzada dos Resultados:

Para garantir que o modelo não estava sobreajustado (overfitting), apliquei validação cruzada com 5 folds, e os resultados foram os seguintes:

- Erro Quadrático Médio (MSE): Média = 0.000260, Desvio Padrão = 0.000032

- Erro Absoluto Médio (MAE): Média = 0.010129, Desvio Padrão = 0.000159

- Coeficiente de Determinação (R²): Média = 0.999564, Desvio Padrão = 0.000054

Os valores obtidos na validação cruzada foram muito próximos dos resultados para as três culturas (soja, milho e trigo), confirmando que o modelo generaliza bem para diferentes partes dos dados e tem uma variabilidade muito baixa em seu desempenho.

3. Insights Gerados Durante a Etapa 1

Durante essa etapa do projeto, alguns insights importantes foram extraídos, o que ajudou a entender melhor os fatores que influenciam o rendimento das culturas e a direcionar as próximas ações. Aqui estão os principais insights:

Insight 1: A temperatura média e a umidade do solo foram as variáveis que mais influenciaram a produtividade das culturas. Isso foi especialmente evidente para o milho, que teve melhor rendimento em temperaturas ligeiramente mais baixas e solo mais úmido. Para a soja, temperaturas mais altas beneficiaram o rendimento, desde que a umidade do solo fosse mantida.

Insight 2: O índice NDVI mostrou ser uma métrica confiável para monitorar a saúde das plantações ao longo do ciclo de crescimento. Regiões com NDVI mais alto tiveram, consistentemente, melhor produtividade, sugerindo que o índice pode ser usado para prever antecipadamente os resultados das colheitas.

Insight 3: As diferenças regionais também impactaram o rendimento. O rendimento do trigo foi maior no Sul, enquanto a soja teve melhor desempenho no Centro-Oeste. Isso indica que a escolha do local de plantio deve ser feita considerando as condições ambientais favoráveis a cada tipo de cultura.

Insight 4: O uso de XGBoost foi decisivo devido à sua capacidade de capturar padrões complexos nos dados. Comparado a outros modelos, como KNN e redes neurais, o XGBoost ofereceu uma combinação ideal de velocidade de processamento e precisão nas previsões, o que foi essencial para lidar com os dados agrícolas voláteis.

Insight 5: A validação cruzada revelou que o modelo é robusto e consistente. Os resultados obtidos foram muito próximos em todos os folds, o que reforçou a confiança no modelo para fazer previsões em dados não vistos.

4. Desafios e Aprendizados

O maior desafio desta etapa foi encontrar um modelo que pudesse prever com precisão os rendimentos agrícolas, dada a complexidade e a interação das variáveis climáticas e de solo. Foi preciso experimentar diferentes algoritmos e fazer ajustes contínuos na engenharia de features, o que exigiu paciência e muitos testes.

Aprendi que a escolha do modelo certo faz uma grande diferença, e que mesmo pequenas alterações na preparação dos dados podem impactar significativamente os resultados. A engenharia de features foi uma etapa crítica para ajustar os dados e melhorar o desempenho dos algoritmos.

5. Próximos Passos e Parte 2 do Projeto

Com a conclusão desta primeira etapa, o foco agora será a Parte 2 do projeto, onde vou explorar a detecção de anomalias nas colheitas e realizar o monitoramento contínuo da saúde das plantações. Vou aplicar técnicas de detecção de anomalias e clustering para identificar áreas de risco e sugerir ações preventivas, com o objetivo de manter as culturas produtivas e saudáveis.

Considerações Finais

A etapa 1 do projeto trouxe resultados satisfatórios e muitos insights valiosos sobre os fatores que influenciam o rendimento agrícola. Esse conhecimento é fundamental para planejar melhor o cultivo e maximizar a produtividade. A ciência de dados mostrou seu potencial para ajudar na tomada de decisões e melhorar a eficiência das práticas agrícolas.

Quero deixar uma resalva que ainda eu podria fazer uma analise muito mais profunda e extrair muito mais informações e insights, esse projeto que é de caracter de estudo e aprendizado dos conceitos.

Espero que este artigo tenha dado uma visão clara do que foi realizado na primeira fase do projeto e dos desafios superados. Em breve, publicarei o artigo da parte 2, onde falarei mais sobre a detecção de anomalias e outras técnicas avançadas de monitoramento. Fiquem de olho e, se tiverem dúvidas ou sugestões, deixem um comentário! 😊

- Caso de Estudo: Deploy de Aplicação para Day Trade Analytics em Tempo Real com Agentes de IA, Groq, DeepSeek e AWS - 7 de julho de 2025

- A engenharia de software e IA - 7 de julho de 2025

- Multiplicação de Matrizes um dos Segredos da IA - 2 de julho de 2025